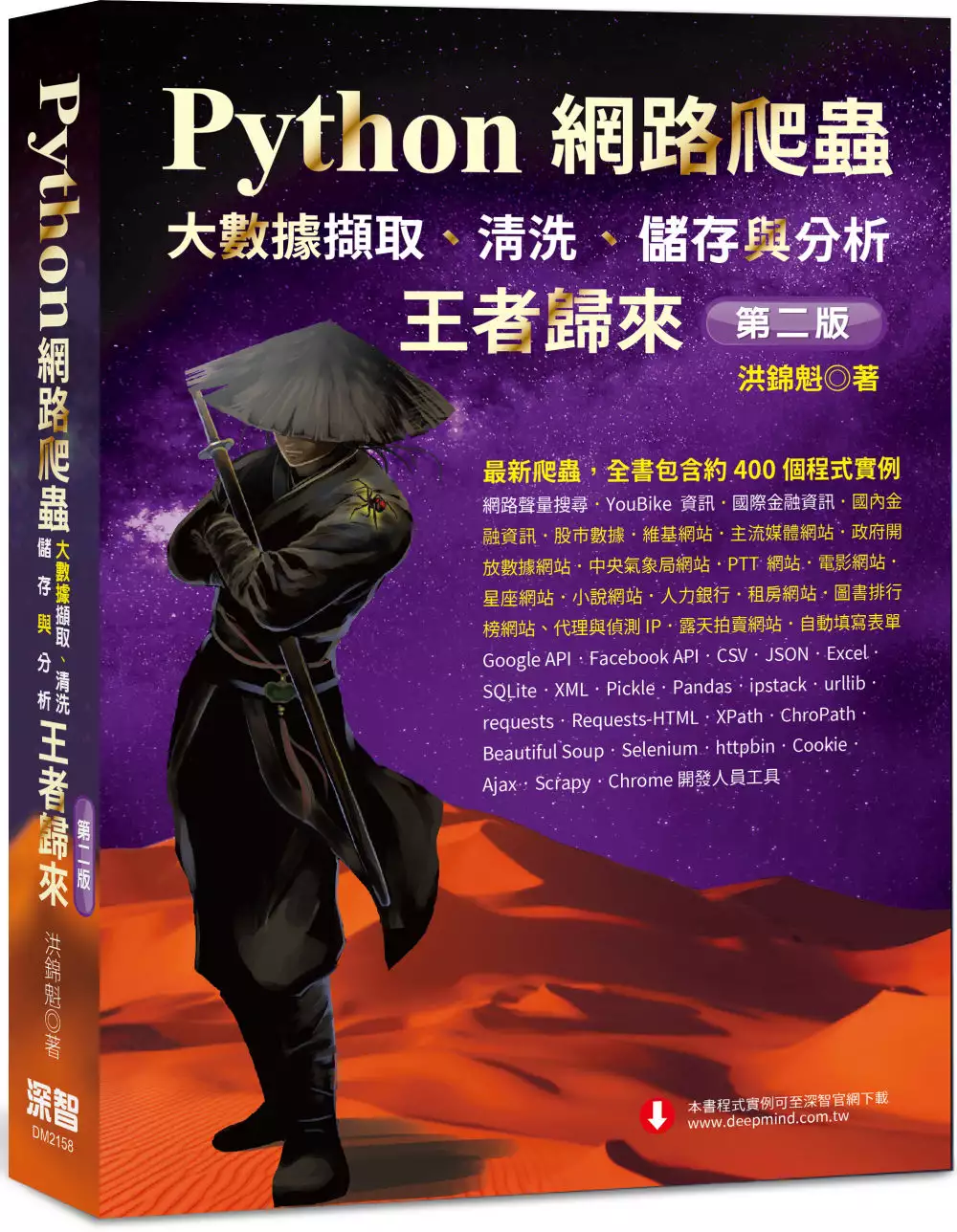

繁體中文亂碼的問題,我們搜遍了碩博士論文和台灣出版的書籍,推薦洪錦魁寫的 Python網路爬蟲:大數據擷取、清洗、儲存與分析 王者歸來(第二版) 和洪錦魁的 Python網路爬蟲:大數據擷取、清洗、儲存與分析:王者歸來都 可以從中找到所需的評價。

另外網站LabVIEW中文版顯示亂碼- NI也說明:我在英文或繁體中文的作業系統環境安裝了中文版本的LabVIEW,為什麼我的LabVIEW界面無法正常顯示中文字? LabVIEW界面上顯示的中文字是亂碼。

這兩本書分別來自深智數位 和深智數位所出版 。

國立臺中科技大學 資訊管理系碩士班 姜琇森所指導 陳立堅的 中文檢索方法改進研析 (2018),提出繁體中文亂碼關鍵因素是什麼,來自於漢字編碼、中文內碼、中文系統、倉頡輸入法。

最後網站Windows 11 簡體中文軟體不再顯示亂碼設定教學則補充:▽切換到地區設定之後切換到『系統管理』頁面,接著可以看到下方『非Unicode 程式目前使用的語言』顯示『中文(繁體,台灣)』,也就是這個設定導致您開啟 ...

Python網路爬蟲:大數據擷取、清洗、儲存與分析 王者歸來(第二版)

為了解決繁體中文亂碼 的問題,作者洪錦魁 這樣論述:

Python網路爬蟲 大數據擷取、清洗、儲存與分析 王者歸來(第二版) ★★★本書第一版是【博客來2020年】【電腦書年度暢銷榜第3名】★★★ ★★★★★【26個主題】+【400個實例】★★★★★ ★★★★★從【零】開始的【網路爬蟲入門書籍】★★★★★ ★★★★★大數據【擷取】、【清洗】、【儲存與分析】★★★★★ ★★★★★【網路趨勢】+【了解輿情】★★★★★ 第二版和第一版做比較,增加下列內容: ★:全書增加約50個程式實例 ★:網路趨勢,了解輿情 ★:網路關鍵字查詢 ★:YouBike資訊 ★:國際金融資料查詢 ★:博客來圖書排行榜 ★:中央氣象局

★:租屋網站 ★:生活應用 下列是本書有關網路爬蟲知識的主要內容: ★:認識搜尋引擎與網路爬蟲 ★:認識約定成俗的協議robots.txt ★:從零開始解析HTML網頁 ★:認識與使用Chrome開發人員環境解析網頁 ★:認識Python內建urllib、urllib2模組,同時介紹好用的requests模組 ★:說明lxml模組 ★:XPath方法解說 ★:css定位網頁元素 ★:Cookie觀念 ★:自動填寫表單 ★:使用IP代理服務與實作 ★:偵測IP ★:更進一步解說更新的模組Requests-HTML ★:認識適用大

型爬蟲框架的Scrapy模組 在書籍內容,筆者設計爬蟲程式探索下列相關網站: ☆:國際與國內股市資訊 ☆:基金資訊 ☆:股市數據 ☆:人力銀行 ☆:維基網站 ☆:主流媒體網站 ☆:政府開放數據網站 ☆:YouBike服務網站 ☆:PTT網站 ☆:電影網站 ☆:星座網站 ☆:小說網站 ☆:博客來網站 ☆:中央氣象局 ☆:露天拍賣網站 ☆:httpbin網站 ☆:python.org網站 ☆:github.com網站 ☆:ipstack.com網站API實作 ☆:Google API實作 ☆:Facebook

API實作 探索網站成功後,筆者也說明下列如何下載或儲存不同資料格式的數據: ★:CSV檔案格式 ★:JSON檔案格式 ★:XML、Pickle ★:Excel ★:SQLite 在設計爬蟲階段我們可能會碰上一些技術問題,筆者也以實例解決下列相關問題: ☆:URL編碼與中文網址觀念 ☆:將中文儲存在JSON格式檔案 ☆:亂碼處理 ☆:簡體中文在繁體中文Windows環境資料下載與儲存 ☆:解析Ajax動態加載網頁,獲得更多頁次資料 ☆:使用Chromium瀏覽器協助Ajax動態加載

繁體中文亂碼進入發燒排行的影片

(美術圖很醜我也吐槽;介面簡體中文是因為繁體中文會變亂碼)

S3PBE上線了 雖然都還在適應不過玩過S1 S2認出很多老面孔

有一些理解跟經驗是S1玩到S3傳承下來的(例如某些排一如既往地假賽)

大家可以跟隨學習理解適應新賽季

也可以等我摸熟了出解說教學在學習 希望大家會喜歡

現在固定在FB直播:https://www.facebook.com/Nye4ni/

斗內滿200星星可以加入專屬的賴群;1000星星可以找NYE教學

喜歡記得訂閱Nye打開鈴鐺接收通知

--------------------------------------------------------------------------------------------------

歡迎加入社群一起討論

DC群邀請碼:https://discord.gg/HyXD7JX

FB社團:https://www.facebook.com/groups/371358526907111/

Nye的FB粉專:https://www.facebook.com/Nye4ni/

中文檢索方法改進研析

為了解決繁體中文亂碼 的問題,作者陳立堅 這樣論述:

中文檢索方式可概分為:字碼、字音、字形。現行電腦中文內碼有國際標準,收錄漢字字數超過八萬字,由中國、香港、臺灣、澳門、日本、韓國、越南等提供。字碼依序而編,各地寫法不同,讀音迥異,究竟要收錄多少漢字,是否重複收錄,人們難以複查。字碼既已難行,字音又有一字多音,多字同音等問題,亦有見字不知讀音,港澳收字為方言音,日韓越之漢字,未必有漢語讀音等。因此,若字音做為檢索方式,未來恐怕難以為繼。故僅剩字形輸入法可兹考慮,如倉頡、大易、嘸蝦米、五筆等。倘按字形編碼,考慮繁簡字、已編定漢字超過五萬之數者,只有第五代倉頡輸入法、蒼頡檢字法。在ISO-10646、萬國碼等國際漢字標準提出後,字碼、字形之老大難

的問題已獲解決。由於漢字收錄工作仍持續進行,臺灣做為繁體字主要使用國,實具備主動出擊的良機。今ISO-10646漢字內碼,仍依序編定。因字數超過八萬字,人工檢索有難度,不易核實收錄漢字是否重複?有無缺漏字等?本文研議沿用第五代倉頡輸入法,提出重碼擴編方式,解決第五代倉頡輸入法,重複字碼位不足的問題。若要核實所有中文內碼標準,如ISO-10646、CNS11643等,則只要建妥轉換表即可。此議,當可令臺灣在漢字文化圈具備一言九鼎的地位,全世界也能重新發現臺灣,彰顯臺灣在中文編碼與中文檢索的巨大貢獻。

Python網路爬蟲:大數據擷取、清洗、儲存與分析:王者歸來

為了解決繁體中文亂碼 的問題,作者洪錦魁 這樣論述:

這是一本使用Python從零開始指導讀者的網路爬蟲入門書籍,全書以約350個程式實例,完整解說大數據擷取、清洗、儲存與分析相關知識,下列是本書有關網路爬蟲知識的主要內容。 # 認識搜尋引擎與網路爬蟲 # 認識約定成俗的協議robots.txt # 從零開始解析HTML網頁 # 認識與使用Chrome開發人員環境解析網頁 # 認識Python內建urllib、urllib2模組,同時介紹好用的requests模組 # 說明lxml模組 # Selenium模組 # XPath方法解說 # css定位網頁元素 # Cookie觀念

# 自動填寫表單 # 使用IP代理服務與實作 # 偵測IP # 更進一步解說更新的模組Requests-HTML # 認識適用大型爬蟲框架的Scrapy模組 在書籍內容,本書設計爬蟲程式探索下列相關網站,讀者可以由不同的網站主題,深入測試自己設計網路爬蟲的能力,以適應未來職場的需求。 # 金融資訊 # 股市數據 # 人力銀行 # 交友網站 # 維基網站 # 主流媒體網站 # 政府開放數據網站 # 社群服務網站 # PTT網站 # 電影網站 # 星座網站 # 小說網站 # 台灣高鐵 # 露天拍賣網站 # ht

tpbin網站 # python.org網站 # github.com網站 # ipstack.com網站API實作 # Google API實作 # Facebook API實作 探索網站成功後,本書也說明下列如何下載或儲存不同資料格式的數據。 # CSV檔案格式 # JSON檔案格式 # XML、Pickle # Excel # SQLite資料庫 本書沿襲作者著作的特色,程式實例豐富,相信讀者只要遵循本書內容必定可以在最短時間精通Python網路爬蟲設計。

繁體中文亂碼的網路口碑排行榜

-

#1.中文亂碼- 维基百科,自由的百科全书

中文亂碼是電子資訊系統的中文無法正確顯示文字符號的一種現象,在中文內碼未有標準時情況尤其嚴重 ... 在過去,由於繁體中文使用者缺乏一個具有號召力的內碼標準,不同使用者都會 ... 於 zh.wikipedia.org -

#2.fox hsiao on Twitter: ""二十多年前,鮮為人知的兩岸三地合作計 ...

那時使用電腦的朋友都記得:假如不想讓對方收到一堆亂碼,寧願用英文寫電子信。 ... 香港的中文大學很恰當地扮演了搭橋的工作,香港跟台灣同樣用繁體字,更重要的是: ... 於 twitter.com -

#3.LabVIEW中文版顯示亂碼- NI

我在英文或繁體中文的作業系統環境安裝了中文版本的LabVIEW,為什麼我的LabVIEW界面無法正常顯示中文字? LabVIEW界面上顯示的中文字是亂碼。 於 knowledge.ni.com -

#4.Windows 11 簡體中文軟體不再顯示亂碼設定教學

▽切換到地區設定之後切換到『系統管理』頁面,接著可以看到下方『非Unicode 程式目前使用的語言』顯示『中文(繁體,台灣)』,也就是這個設定導致您開啟 ... 於 mobileai.net -

#5.在线文字识别转换- 免费图片转文字工具OCR - 在线工具系列

我们的Ocr服务支持中文、繁体中文、日语、韩语、英语、法语、俄语、德语等多种语言, ... 请不要选择“自动识别”,因为方向存在一定概率识别错了,从而造成整页乱码. 於 ocr.wdku.net -

#6.繁體中文亂碼-在PTT/MOBILE01/Dcard上的毛小孩推薦資訊整理

2022繁體中文亂碼討論資訊,在PTT/MOBILE01/Dcard上的毛小孩推薦資訊整理,找亂碼轉換工具,繁體中文亂碼,亂碼文字產生器在Instagram影片與照片(Facebook/Youtube)熱門 ... 於 lovepet.gotokeyword.com -

#7.經常下載大陸文件都是亂碼怎麼辦下載大陸破解碼是亂碼 ... - LE

或是將文字複製起來,貼到Word裡面,. 再用word的「繁體簡體切換功能」就可以轉換成繁體中文了。 於 t0916352437j.pixnet.net -

#8.電腦1週: PCStation Issue 1117 - 第 23 頁 - Google 圖書結果

解決方法很簡單,就是改變系統的語系,令系統以 GBK 內碼來處理中文,如此一來,輪到繁體軟件出現亂碼了。微軟為了解決這個問題,提供了一個《 AppLocale 》程式, ... 於 books.google.com.tw -

#9.Airiti Library華藝線上圖書館

中文 圖書全文檢索服務,深度探索知識,全面蒐集圖書,便於寫作時回查、回補出處。 ... 答客問_註冊與登入問題 答客問_收不到認證信 答客問_全文空白或亂碼 答客問_購買 ... 於 www.airitilibrary.com -

#10.轉換成"カタカナ"(平假/片假名轉換教學)<日文網頁註冊時-姓名 ...

本文來教大家,如何將自己的中文姓名(漢字)轉換為日文網頁註冊時需要輸入的平 ... 要選"unicode",這樣才能把日文字保存下來,否則下次打開會亂碼喔! 於 ksk.tw -

#11.繁簡體mail會出現亂碼嗎? - iT 邦幫忙

因為這種編碼大多出現在中文郵件上。因此,當亂碼出現時首先應當檢查編碼方式是否為“繁體中文〔Big5〕”,如果不是,可用選取「檢視」選單 ... 於 ithelp.ithome.com.tw -

#12.【教學】解決簡體文字亂碼txt、中文網頁亂碼,線上轉換

首先這是我們要解決亂碼的簡體文字,檔案類型為txt,若在網站中遇亂碼也可直接編碼設定,或word內遇到亂碼也可先複製到記事本在依照下面步驟操作。 簡體亂碼轉換txt5. 於 www.techmarks.com -

#13.各類所得憑單含信託資料電子申報-軟體下載與報稅

如作業系統為Windows 7,且於安裝完成後中文出現亂碼: ... 英文(美國),按確定;然後再重新做一次,把語言選回中文(繁體, 台灣),選擇確定後,重新開啟報稅軟體即可。 於 tax.nat.gov.tw -

#14.IT應用系列 (39):USB手指終極強化活用術: < 終極強化USB手指,工作娛樂樣樣掂!>

繁體中文 Plugin:留意 PE Builder 不支援中文版的 Windows XP/2003,否則製作出來的流動操作系統會出現亂碼。如果大家有需要顯示和輸入中文,可下載中文化的 ... 於 books.google.com.tw -

#15.[Windows] 解決英文版Windows 7執行中文軟體顯示亂碼

按鈕,將預設語言變回到「中文(繁體,台灣)」,再按下「套用」,就可以開始正常的顯示方才執行為亂碼的程式了。 其實似乎應該從英文版的Windows 7再作 ... 於 mrmo.cc -

#16.DrawString 中文亂碼: Spire.PDF - E-Iceblue

Text,內容為中文,這樣的方式,中文會變亂碼。 程式碼如下: 'Create one page ... 當使用繁體中文的時候,這裡有2個解決方案能解決中文亂碼問題。 於 www.e-iceblue.com -

#17.利用編碼設定解決亂碼問題- Google Merchant Center說明

如果您打開.txt 檔的Google 產品分類時發現內容是亂碼, ... 您無法調整Chrome 的編碼設定,不過您可以試著利用擴充功能來修正亂碼的問題。 ... 中文(繁體). 於 support.google.com -

#18.繁簡中文字亂碼解決方案 - 月光部落

繁簡中文字亂碼解決方案 · 2. 在文本的上面按「滑鼠右鍵」→「開啟檔案」→「選擇其他應用程式」 · 3. 彈出「其他選項」視窗,請選擇「Google Chrome」瀏覽器,然後按「確定 ... 於 www.moonlol.com -

#19.解決電腦中文變亂碼的方法( 讓電腦正確顯示中文) - 隨意窩

解決電腦中文變亂碼的方法( 讓電腦正確顯示中文). 打開[ 控制台]. 選擇[ 地區] 或. 選擇[ 時鐘、語言和區域],在選擇[ 地區]. 檢查格式是否為[ 繁體 ... 於 blog.xuite.net -

#20.簡體中文遊戲或程式在繁體中文作業系統中顯示亂碼的解決方法

按WinKey + R 開啟執行對話方塊,執行intl.cpl,開啟「地區及語言選項」 Windows XP / Server 2003 地區及語言選項» 進階» 非Unicode 程式的語言» ... 於 idaiwan.pixnet.net -

#21.乱码文字生成器 - 千千秀字

文字乱码,多数时候都是因为字符在传输、存储过程中使用了不一致的编码造成的。本页面可观察到本地化编码读取UTF-8文本造成乱码的情况,可选择本地化编码类别。 於 www.qqxiuzi.cn -

#22.顯示亂碼?Windows系統中解決繁體字最佳方法 - 人人焦點

其實亂碼產生的主要原因是港台Windows所使用的語言代碼頁是Big5編碼,而 ... 只要在現有的硬碟劃分出一定空間再安裝一個繁體中文版的Windows即可。 於 ppfocus.com -

#23.[科普] 超详细的乱码原因解释,与使用UTF-8 一劳永逸的解决乱码

5.2win10和win11 繁体 系统使用本软件解决系统 乱码 设置步骤. invest模型文件编码改为UTF-8 ... 再也不怕 中文乱码 了,10分钟教你怎么把gbk转成utf8站点. 於 www.bilibili.com -

#24.文字亂碼轉換| 中日韓 - 線上工具

中文亂碼 ﹑簡體亂碼﹑繁體亂碼﹑韓文亂碼﹑日文亂碼. 於 www.ifreesite.com -

#25.馴碼快手(簡體亂碼文字轉換成繁體) - 小克藝想世界 - Udn 部落格

再多說一點…當您下載並執行了上述程式後,看到了中文亂碼: 如果您的Windows是繁體中文版的話,請按「Ctrl ... 於 blog.udn.com -

#26.英文版本Windows10 / Windows Server 2012 中文顯示亂碼 ...

這是因為有些舊版的中文軟體並未支援Unicode。 此時即使你安裝Windows 官方的繁體中文語言包,切換顯示語言為繁體中文。 於 itorz324.blogspot.com -

#27.Filezilla傳輸軟體中文出現亂碼排除方法 - 智邦小幫手

1、因中文編碼有BIG5及UTF-8,若不是使用正確字碼連線,中文目錄或檔名,會有亂碼情形,導致無法刪除或更名。 2、打開站台管理員,在「字碼集」,請選擇: 強制使用UTF-8 ... 於 help.url.com.tw -

#28.Ubuntu 中文顯示設定 - Medium

試著vim 輸入中文,也是顯示亂碼。 到這邊大概確定是系統不支援中文問題,先用指令查目前語系 $ localeLANG=en_US.UTF ... 於 medium.com -

#29.SAS 程式(SAS 9.4) 繁體中文出現亂碼怎麼辦? - SAS Taiwan

Q: SAS 程式(SAS 9.4) 繁體中文出現亂碼怎麼辦? A: 主要發生原因是因為近期Windows 作業系統更新,. [解法] 請至控制台> 地區設定,將” Beta: ... 於 blogs.sas.com -

#30.安裝軟體時選擇了繁體中文語系,但是軟體的介面卻反而變亂碼?

它有支援繁體中文的軟體,但是中文介面卻顯示出亂碼時,也可以利用同樣的思維,從兩個層面去嘗試解決亂碼問題: · 1.看看軟體本身有沒有可以修改字型的地方: · 2.回到佈景 ... 於 www.playpcesor.com -

#31.txt的簡繁體轉換和簡體程式亂碼的解決方案 - 小羔羊分享站

以下將對純文字的簡繁體字轉換,以及非繁體中文程式顯示亂碼的問題,做個別的解決 ... [big5],這是繁體字的編碼格式,在不是繁體的系統上會變成亂碼 ... 於 lamb.tw -

#32.另一種中文化: 啟用繁體中文語系- 流亡編年史, Path of Exile Wiki

實況玩家: 使用中文化在twitch 上實況會被發警告, 這部分是為了不能變相鼓勵玩家修改遊戲檔案。 Steam 或EPIC 版本: 因Steam 和EPIC 均不提供 ... 於 poedb.tw -

#33.Locale Emulator 2.5.0.1 中文版- 讓軟體正常顯示簡體中文或 ...

讓軟體正常顯示簡體中文或其他語言- Locale Emulator,如果軟體非本國語系又不支援萬國碼(Unicode),那麼開啟的時候就會顯示為亂碼,如果是Windows ... 於 www.azofreeware.com -

#34.显示乱码?Windows系统中解决繁体字最佳方法-搜狐数码天下

喜欢玩游戏的人都会遇到一个尴尬:港台出品的繁体游戏在简体中文Windows下显示乱码的问题,给我们带来了极大的不便。其实乱码产生的主要原因是港 ... 於 digi.it.sohu.com -

#35.如何讓【簡體中文軟體】的亂碼可以在Windows 中顯示正常 ...

有些時候我們可能需要在電腦中安裝或使用簡體中文的軟體,但在某些情況下少部分簡體中文介面的軟體可能無法在繁體中文的Windows 系統中正常顯示, ... 於 briian.com -

#36.如何讓Windows 11 正確顯示軟體語言不亂碼? - 海芋小站

windows 11 1 language · 首先,進入設定中,先擇語言與地區(下圖中第二個位置)。 · 再來,將語言設為繁體中文,地區和地區格式設為台灣和中文。 · 最關鍵的 ... 於 www.inote.tw -

#37.Fate/EXTELLA LINK - 繁體中文亂碼問題解決方式

Fate/EXTELLA LINK > Общи дискусии > Подробности за темата. olaf8940 · Преглед на профила Преглед на публикации. 1 май 2021 в 2:49. 繁體中文亂碼問題解決方式. 於 steamcommunity.com -

#38.網絡管理員在線工具- Garbled Message

在線亂碼字符解碼,解碼簡體中文亂碼,繁體中文亂碼以及日文和韓文亂碼. 於 www.mxcz.net -

#39.繁体系统下如何快速将简体安装文件乱码恢复正常? - 博客园

很多情况下,我们个人或集体使用的Windows操作系统不仅仅是简体中文环境,也有英文/繁体中文语言环境。 有时候会需要安装不同语言环境的程序(软件) ... 於 www.cnblogs.com -

#40.Excel VBA中文亂碼:更改編輯環境語言或重新輸入

一、VBA繁體中文 · 二、英文介面亂碼 · 三、執行亂碼程式 · 四、程式執行錯誤 · 五、VBA Debug偵錯 · 六、工具選項設置 · 七、字型撰寫風格 · 八、顯示繁體中文 ... 於 zanzan.tw -

#41.簡體亂碼轉繁體 - PIEDESTAL

請問繁體中文(BIG5)與簡體中文(GB2312)的轉換問題- Mobile01. English ⚬ 简体中文⚬ 繁體中文⚬ ภาษาไทย ⚬ 한국어⚬ 粵語⚬ Tiếng Việt ⚬ 日本語⚬ ... 於 shoesbypiedestal.fr -

#42.【經驗談】英文版Win10遇到中文顯示亂碼的解決方法 - 歐飛先生

網友在我要裝英文版的WIN10及Office 中留言: 如果客戶要能存放繁體中文檔名且正常顯示,就得像先安裝繁體中文版,再更換顯示介面為英文。 於 ofeyhong.pixnet.net -

#43.ProFTPD UseEncoding 繁體中文亂碼解決Localization - 小惡魔

... 中文環境 UseEncoding UTF-8 GBK # 繁体中文環境 UseEncoding UTF-8 Big5 Reference: ProFTPD module mod_lang centos上解決proftp中文亂碼問題. 於 blog.wu-boy.com -

#44.如何將亂碼簡體檔名、資料夾在繁體電腦正常顯示

如果我們將簡體文件(大陸環境)所壓縮的檔案,帶到繁體中文電腦(台灣環境),解壓縮之後,就會看到一堆亂碼的檔名與資料夾。這原因是因為兩邊電腦的語系 ... 於 blog.hungwin.com.tw -

#45.windows 10安裝簡體軟體會出現亂碼問題 - Mobile01

至於原始版(for win95/98)能不能直接在繁中Win10上跑,我就不知道了,反正現在有原生支援的網路授權版,不用去操那個心了。哪天心血來潮再翻出CD來實驗看 ... 於 www.mobile01.com -

#46.英文版OS安裝AP不顯示亂碼的處理方式-XQ全球贏家

1.開啟控制台/時鐘、語言和區域/點選地區及語言 · 2.開啟“格式”,確認是否為繁體中文 · 3.系統管理/非Unicode程式的語言/變更系統地區設定. 於 www.xq.com.tw -

#47.如何解决玩繁体游戏在简体中文Windows下显示乱码的问题

在简体中文Windows系统上玩繁体游戏显示乱码,要怎么办. 乱码产生的主要原因是由于繁体游戏所使用的语言代码页是Big5编码,而我们使用的是国标(GB), ... 於 weishi.360.cn -

#48.[伊蒙dev c++] 中文亂碼的解決方法傳說中的許功蓋

因ASCII碼只能用以表示大小寫英文字母、阿拉伯數字及特殊符號,無法表示繁體中文字,因此,國人針對繁體中文設計了許多不同的編碼系統,如BIG-5(又稱 ... 於 lotos99.pixnet.net -

#49.【Creo】08-中文字體變亂碼解決之道 - 假許起手式

我們來講講在Creo Parametric 中文字體變亂碼要如何解決情境: 工程圖裡中文 ... 安裝過程勾選需要安裝的語言,勾選「繁體中文」如果需要簡體字,則複 ... 於 joshups.com -

#50.告別簡體亂碼的兩種方式,只要一瞬間! - 次元裂縫

在觀看TXT文件時,打開來卻是簡體字的亂碼,總是令人直冒冷汗、不知所措嗎? 這個軟體解決了你的痛苦!GB5! ... Ctrl + → 簡體亂碼→ 繁體中文。 於 e36272123.pixnet.net -

#51.WIN10显示中文乱码,应该如何设置? - 知乎

说说我的经历,我想用英文版的win10,设置完,就开始用了。 没想到,过了两个星期,发现我的visual stdio 认不出中文了,而且不仅是注释,连代码中出现的中文字符都 ... 於 www.zhihu.com -

#52.解決Windows 11 安裝簡體中文或非Unicode 程式出現的亂碼問題

如果你會經常交錯使用繁中和簡中的程式,這個方法就不適合,因為需要將語言更改回來否則開啟繁中的程式時就可能遭遇亂碼問題,若只是偶爾需要用一下簡體中文程式或只是 ... 於 free.com.tw -

#53.搜索结果_繁体系统显示简体乱码 - 百度知道

在控制面板-区域语言选项-添加删除语言- 繁体中文- 注意、这里要改非unicode程序语言、一定要是繁体中文才可以。 2017-04-17 藍色海洋0909. 繁体系统显示乱码简体字 ... 於 iknow.baidu.com -

#54.visual studio繁体中文乱码解决方法_xw13106209的博客

我用的visual studio是简体中文版,打开繁体项目的时候,所有繁体中文都变成了乱码,这样也导致了有些方法和变量出现乱码,从而导致整个程序出现错误 ... 於 blog.csdn.net -

#55.解決IDM在繁體中文系統下出現亂碼 - 简书

我的電腦是這樣的:使用的系統是Windows 10 版本1709,語言為繁體中文(香港)。但由於平時亦會使用簡體中文軟件,因此「非Unicode 程式的語言」這一 ... 於 www.jianshu.com -

#56.[cmder] 解決中文顯示亂碼 - OneJar 的隧道

cmder terminal 的standard output 顯示中文會變成亂碼: ... albert's blog: [Tools] [Cmder] 繁體中文亂碼問題 · {oc.tech.notes} 技術誌: [Cmder] ... 於 www.onejar99.com -

#57.三國志11 威力加強版下載– zh002

1 三國之戀XI威力加強版下載1.1 三國之戀11(最新世代)繁體中文強力加強版PK ... 繁體中文【是否亂碼】:是【授權類型】:硬盤版(不含三國志11繁體中文版主程序) ... 於 zh002.shortennews.com -

#58.帳號復原、安全和資料– 《英雄聯盟》客服

帳號復原、安全和資料 ; Garena帳號轉移支援 · 《英雄聯盟》造型價位 · 東南亞歡迎活動 ; 修改帳號和登入 · 全球帳號:《英雄聯盟》 · Riot帳號:使用者名稱變為亂碼 ; 帳號 ... 於 support-leagueoflegends.riotgames.com -

#59.Python 中文编码 - 菜鸟教程

Python 中文编码前面章节中我们已经学会了如何用Python 输出'Hello, World!',英文没有问题,但是如果你输出中文字符'你好,世界' 就有可能会碰到中文编码问题。 於 www.runoob.com -

#60.誠華OCR - 圖片轉文字- 免費在線OCR

... norsk, polski, português, русский, slovenský, svenska, ภาษาไทย, Tiếng Việt, English, 简体中文, 繁體中文. 登錄 註冊 · 誠華OCR - 圖片轉文字- 免費在線OCR. 於 zhtw.109876543210.com -

#61.這是一本SketchUp to LayOut的書:用一半時間畫兩套彩色施工圖(增修版)

... ( Auto - Text Enables )這個自動標示標籤必須要先操作找回中文版剪貼簿後才能看的到喔! ... 將圖塊拉到繁體中文版的畫面後可能會出現亂碼,這是筆者目前測試的結果。 於 books.google.com.tw -

#62.【閒聊】不靠官方靠我們自己來解決繁體中文亂碼的問題

有幾個繁體中文比較久遠會亂碼的翻譯票數比較高有時候有人投贊成票的時候就會超過我的修正翻譯需要大家幫忙投反對票把票數降下來降到1或0就差不多 ... 於 forum.gamer.com.tw -

#63.Win10英文版完美顯示中文字 - Tomex Ou 專業部落格

... 其英文UI介面下是可以正常顯示中文的,但遇到ANSI編碼的中文檔案會出現亂碼,這問題可以在控制台Region下,設定Non-Unicode語言為繁體中文Taiwan ... 於 tomex.dabutek.com -

#64.Localization (正體中文)/Traditional Chinese (正體中文)

在Arch Linux 中,透過設置 /etc/locale.conf 文件,來設置語系環境。 LANG=en_US.UTF-8. 注意: 不推薦在這裡設置中文語系,會導致tty 終端機亂碼。如果 ... 於 wiki.archlinux.org -

#65.比特幣區塊鏈大未來: 繁體中文語系第一本比特幣區塊鏈的專書

繁體中文 語系第一本比特幣區塊鏈的專書 張渝江 ... 掃描Bob店的QR code(二維條碼),Bob店的QR Code其實是一個數字1開頭25~34碼看來像亂碼的位址 19 我在本書後續會說明 ... 於 books.google.com.tw -

#66.簡體亂碼轉繁體 - O MIKROBIOMIE

说明:请输入要转换简繁体的中文汉字,然后点击"简体转繁体"或"繁体转简体"按钮,即可将正体繁体字、中文简体字或QQ非主流繁体字转换翻译汉字繁简体。. 请将 ... 於 omikrobiomie.pl -

#67.線上文字亂碼還原工具

字串亂碼?簡體中文亂碼?就使用亂碼還原工具吧!點一下「恢復亂碼」按鈕,然後對照下面的編碼,就能找出原本的文字是什麼。 於 www.toolskk.com -

#68.Windows 10命令提示字元中文顯示亂碼 - 21點情報網

Windows 10在命令提示字元無法正常顯示中文,而看到一堆亂碼,原因是命令提示字元的 ... 936 中國– 簡體中文(GB2312); 949 韓文; 950 繁體中文(Big5) ... 於 ailog.tw -

#69.觀看文章- [教學]如何讓中文語系Linux的文字模式永遠不出現亂碼

語系多半都會選擇繁體中文(zh_TW.Big5) 雖然在進入X Window 時,就可以看到美美的中文字但是在文字模式下,所有的訊息就會變成亂碼實在是很麻煩 於 www.csie.ntu.edu.tw -

#70.解決電腦簡體字(???) 亂碼的設定 - YouTube

注意:記得使用完畢後要再改回台灣 繁體 字,否則有些 繁體 字的軟體也會變成 亂碼 ! 於 www.youtube.com -

#71.中文乱码? | SAP Community

环境. OS: WINDOWS 7 简体中文. 输入法: 极点五笔6.5. SAP GUI: 7100.3.11.1042 补丁:11. 1. 在T-CODE SO10里: 输入繁体中文,保存离开, 再以 ... 於 answers.sap.com -

#72.輕小說文庫- 最新最全的日本動漫輕小說在線閱讀與下載基地

<10.05.30>為提高繁體用戶的網站使用體驗,解決繁體版的亂碼問題,文庫現新增“繁體化”功能。 <09.03.19>文庫WAP版開通,歡迎大家用手機直接訪問︰wap.wenku8.com,支持在線 ... 於 www.wenku8.net -

#73.visual studio繁体中文乱码解决方法 - 阿里云开发者社区

我用的visual studio是简体中文版,打开繁体项目的时候,所有繁体中文都变成了乱码,这样也导致了有些方法和变量出现乱码,从而导致整个程序出现错误 ... 於 developer.aliyun.com -

#74.Google 翻譯

中文 (繁體). 中文(繁體). 英文. 中文(簡體). 原文語言. search. close. clear. checkhistory. 偵測語言. auto_awesome. 最近使用過的語言. 所有語言. checkhistory. 於 translate.google.com.tw -

#75.記事本中文會自動亂碼? - Microsoft 社群

我們了解到您關於Windows 10中文亂碼的問題,. 您可以先嘗試以下方案進行操作,看看結果如何:. 控制台>>時鐘和區域>>更改日期、 ... 於 answers.microsoft.com -

#76.首頁 - MEGA

這意味著只有發送者和接收者擁有查看、讀取或監聽儲存在MEGA上或共享資料所需的金鑰。 對於包括MEGA在內的其他任何人,這些資料看起來都是亂碼,無法閱讀或理解。 於 mega.io -

#77.Markdown 語法新手教學(文字格式:粗體,斜體,底線)

繁體中文. Dansk Deutsch English (US) Español Français हिन्दी (भारत) Italiano 日本語 한국어 Nederlands Polski Português do Brasil Русский svenska ... 於 support.discord.com -

#78.查詢資料集: 全部資料| 政府資料開放平臺

資料集列表| Datasets · 行政院 · 內政部 · 外交部 · 國防部 · 財政部 · 財政部國庫署 · 財政部統計處 · 財政部國有財產署 ... 於 data.gov.tw -

#79.5天學會軟體中文化: 全球第一本中文化技術入門專書

... 一旦你開啟翻譯完成後的 RC 資源檔,會看到資源項目的內容全數變成亂碼。 ... 此時讀者只需將「RC 資源檔」中有關語系的部份全數以繁體中文語系的值取代即可(有關 ... 於 books.google.com.tw -

#80.關於中文頁面名稱亂碼的解決方法(一) - DokuWiki

如果您使用中文(或中日韓字符)命名,它會被轉換成貌似亂碼的字符串,但其實那是特別的代碼 ... 比較遺憾的是,文件名是亂碼。 ... CP936是簡體中文、CP950是繁體中文. 於 www.dokuwiki.org -

#81.解決應用程式的亂碼Win10專用的Locale Emulator 取代 ...

但是功能上他還能讓特定的應用程式以虛擬的區域來進行模擬運作,像是在設定為台灣、繁體中文作業系統的電腦上,讓軟體待在一個虛擬為日文作業系統、 ... 於 www.kocpc.com.tw -

#82.簡體亂碼轉繁體 - Dietetyk Niemcy

说明:请输入要转换简繁体的中文汉字,然后点击"简体转繁体"或"繁体转简体"按钮,即可将正体繁体字、中文简体字或QQ非主流繁体字转换翻译汉字繁简体。. 请将 ... 於 dietetykniemcy.pl -

#83.UTF-8转换工具

UTF-8编码在线转工具可以帮助你把中文转换成UTF-8编码,同时也支持把UTF-8编码过的还原成中文。 於 tool.chinaz.com -

#84.如何將亂碼簡體檔名、資料夾在繁體電腦正常顯示 - Matters

如果我們將簡體文件(大陸環境)所壓縮的檔案,帶到繁體中文電腦(台灣環境),解壓縮之後,就會看到一堆亂碼的檔名與資料夾。這原因是因為兩邊電腦的語系 ... 於 matters.town -

#85.解決WIN10軟體安裝程式亂碼 - 小小初心者的筆記- 痞客邦

跳出新視窗,查看是否為中文(繁體,台灣),然後下方"不用"打勾!! image. 按下確定後,電腦會要你重新啟動,重新啟動後再去點 ... 於 docu2019ment.pixnet.net -

#86.Android 軟體下載免費版,解鎖版-Android 台灣中文網 - APK.TW

[獨家]手機列印(移動打印) NokoPrint Premi; 【最新版】Genius Scan Enterprise 精靈掃; 山頭辨識PeakFinder v4.7.6 繁體中文付費; MX播放器專業版MX Player Pro ... 於 apk.tw -

#87.Jenkins on Windows 心得分享(03):有效避免記錄檔或訊息 ...

想當然爾Jenkins 也不例外,在許多使用情境下,遇到中文都會有亂碼的 ... 所以,要等Windows 繁體中文版的作業系統將預設編碼改成Unicode 應該還要再 ... 於 blog.miniasp.com -

#88.ConvertZ - 把簡體亂碼的小說,變成繁體中文! - willy的部落格

檔案名稱:ConvertZ檔案版本:8.0.2.1檔案語言:繁體中文軟體下載:點我下載資料夾內容物(點擊ConvertZ.exe) 他會把工具列隱藏在畫面最上方點選檔案 ... 於 willy84567.pixnet.net -

#89.LINE官方帳號輕鬆貼近好友 - LINE Biz-Solutions

你可以透過「專屬ID」制定一組好記的品牌ID,讓你的ID不再是難記的隨機亂碼! 163128cdad1c10524e95eda772bb25e2.jpg. e6b12e4970bf0fa07410f3e4457e04c1.png. 於 tw.linebiz.com